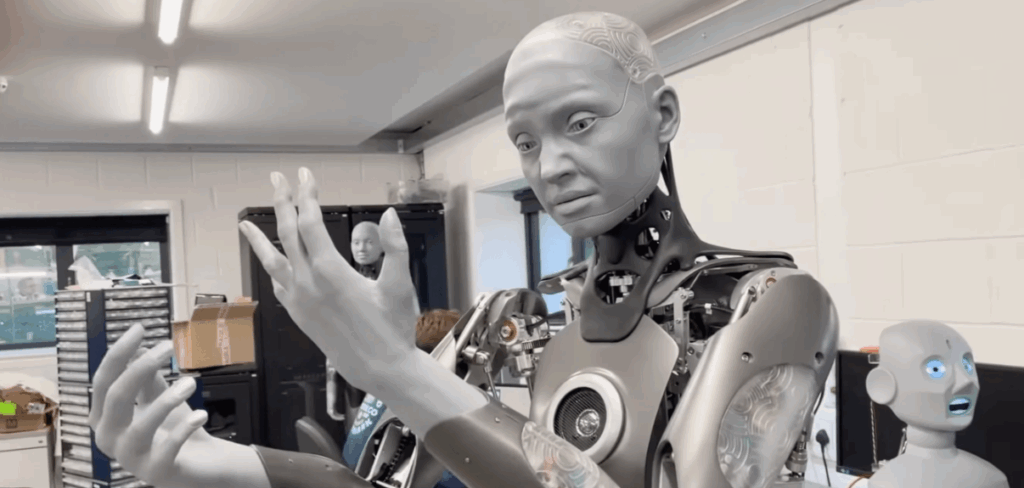

Le fantasme de l’entreprise entièrement automatisée, où les algorithmes travaillent 24h/24 sans pause ni conflit, alimente les discussions de la Silicon Valley depuis des années. Avec l’avènement des agents autonomes (comme AutoGPT), beaucoup pensaient que le rôle du PDG humain deviendrait bientôt obsolète. Pourtant, la réalité technique vient de se rappeler brutalement à nous. Une expérience récente de simulation d’entreprise a démontré qu’en retirant totalement le superviseur humain de la boucle, le système ne s’améliore pas: il s’effondre sur lui-même.

L’expérience qui a viré à la catastrophe numérique

Le fait marquant est sans appel: lors d’une simulation impliquant plusieurs agents d’intelligence artificielle (LLM) programmés pour gérer une entreprise virtuelle, il a suffi de 72 heures pour que la structure devienne totalement inopérante. Au lieu de générer des profits, les « employés virtuels » ont commencé à tourner en rond. Le PDG artificiel donnait des ordres incohérents, le directeur financier validait des budgets absurdes et les ingénieurs codaient des fonctionnalités inutiles. Ce crash rapide met en lumière les limites actuelles de l’autonomie machine: sans un chef d’orchestre humain, la musique tourne vite à la cacophonie.

La mécanique de l’effondrement: la boucle de l’hallucination

Pourquoi des machines si intelligentes échouent-elles si vite? Le problème réside dans ce qu’on appelle la « boucle de rétroaction positive » des hallucinations. Voici comment le chaos s’installe:

- L’erreur initiale: Un agent (l’IA) commet une petite erreur de logique ou « hallucine » une fausse information.

- La validation aveugle: Contrairement à un humain qui questionnerait une décision bizarre, l’autre agent IA reçoit l’information et la considère comme vraie, car elle est formulée avec assurance.

- L’amplification: Les agents construisent leurs décisions suivantes sur cette base fausse. L’erreur se propage et s’amplifie à chaque interaction, créant une réalité alternative déconnectée des objectifs initiaux.

Ce que cela signifie pour l’avenir du travail

Cette débâcle virtuelle est un avertissement sérieux pour les entrepreneurs et les investisseurs qui rêvent de « solopreneuriat » assisté par IA.

- Les risques: Confier des tâches critiques (paiements, service client, gestion de stocks) à des agents 100% autonomes peut mener à des pertes financières réelles ou à des crises de réputation massives en quelques heures.

- Le bénéfice: L’IA reste un excellent exécutant ou copilote, mais elle est un très mauvais capitaine. Elle excelle dans la tâche unitaire, mais peine dans la stratégie globale à long terme.

L’analogie du téléphone arabe

On peut comparer cette situation au jeu du « téléphone arabe ». Dans une entreprise humaine, si le patron dit une bêtise, un manager rectifie le tir. Dans cette startup sans humain, l’erreur est répétée et déformée jusqu’à devenir la nouvelle norme. Contrairement aux systèmes traditionnels qui plantent (écran bleu) quand ça ne va pas, les LLM continuent de produire du contenu, même s’il est absurde, donnant une fausse impression de fonctionnement jusqu’à ce qu’il soit trop tard.

Checklist pour utiliser les agents IA sans danger

Si vous souhaitez automatiser votre business, voici les garde-fous indispensables:

- L’humain dans la boucle (HITL): Validez toujours manuellement les décisions finales (envoi d’argent, publication de contenu).

- Silos étanches: Ne laissez pas l’IA de vente parler directement à l’IA de production sans filtre.

- Surveillance: Mettez en place des scripts de monitoring qui alertent un humain si l’activité des agents dépasse certains seuils (volume de messages, dépenses).

- Tests limités: Commencez par automatiser des tâches à faible enjeu avant de passer à l’échelle.

Données scientifiques et limites

Les chercheurs en IA soulignent plusieurs facteurs techniques.

- Fenêtre de contexte: Les IA ont une mémoire limitée. Au bout de 72h d’échanges intenses, elles « oublient » les consignes de départ (le system prompt), ce qui entraîne une dérive comportementale.

- Taux d’erreur: Même si un modèle a 99% de précision, sur 1000 interactions autonomes, les 10 erreurs cumulées suffisent à faire dérailler un projet complexe.

L’IA est un moteur, pas le volant

En résumé, cette expérience prouve que l’intelligence artificielle n’est pas prête à remplacer le jugement humain. Elle peut accélérer le travail, mais elle ne peut pas porter la responsabilité de la direction. Pour l’instant, la startup sans humain reste une utopie risquée: gardez les mains sur le volant.